至顶智库 | 从苹果秋季发布会到苹果AI发展史 原创

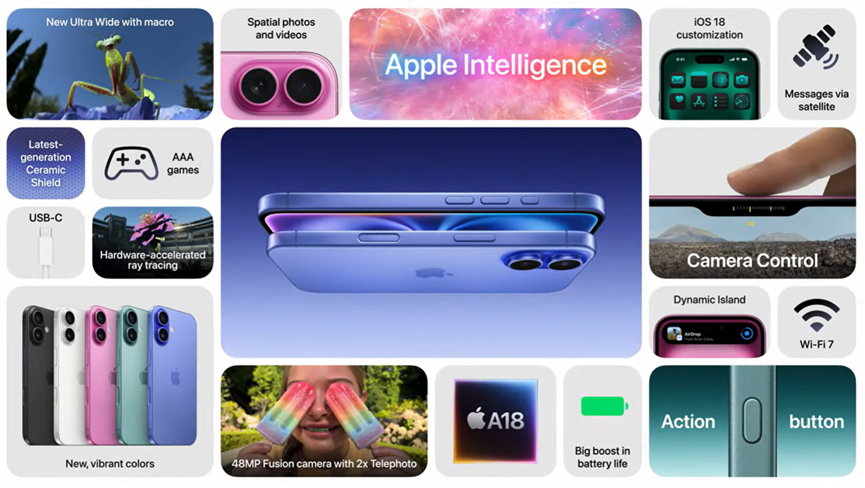

北京时间2024年9月10日凌晨,苹果召开一年一度的秋季新品发布会,今年以AI为亮点,吸引全球广泛关注。发布会以iPhone 16等重磅产品为核心,主打Apple Intelligence智能应用、AI芯片及全新机型。

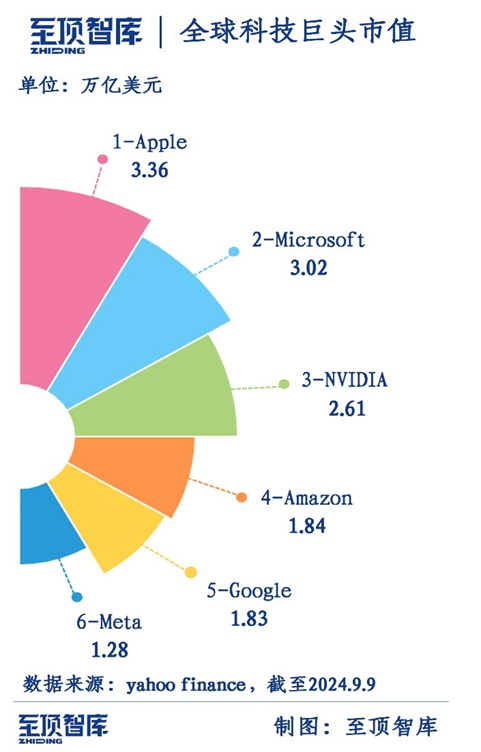

苹果公司(Apple)作为科技行业的领军者,多年来在消费电子领域引领全球科技发展方向,苹果的发展势头也反映到公司市值上。至顶智库通过梳理全球六大科技巨头的市值,苹果公司位居首位,市值达到3.36万亿美元,微软、英伟达等紧随其后,苹果(AAPL)成为全球投资者热捧的科技股票。

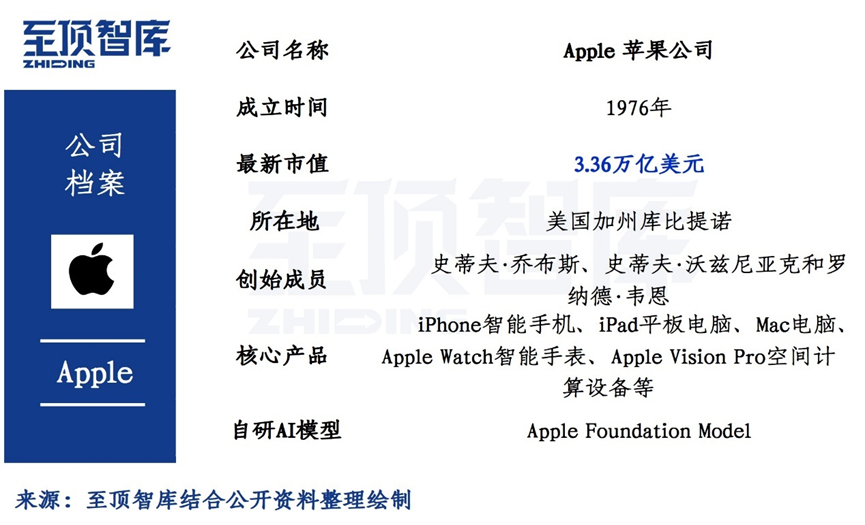

苹果公司(Apple Inc.)是一家跨国科技公司,专注于消费电子领域。总部位于美国加利福尼亚州库比提诺。由史蒂夫·乔布斯、史蒂夫·沃兹尼亚克和罗纳德·韦恩于1976年创立。苹果公司以设计、开发和销售消费电子产品、计算机软件和在线服务而闻名。公司主要产品涵盖iPhone智能手机、iPad平板电脑、Mac电脑、Apple Watch智能手表、Apple Vision Pro空间计算设备等硬件产品以及相关软件和服务。

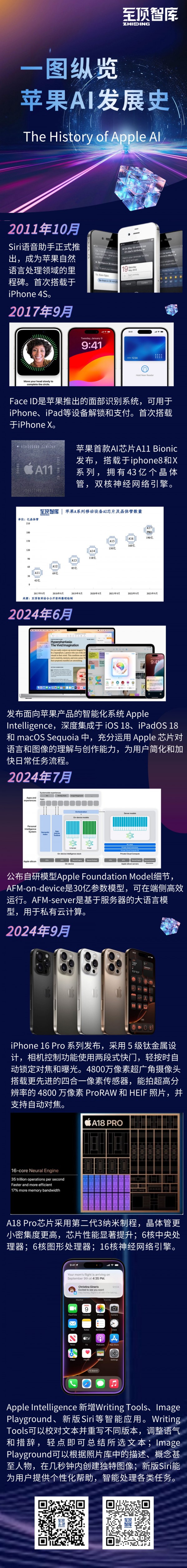

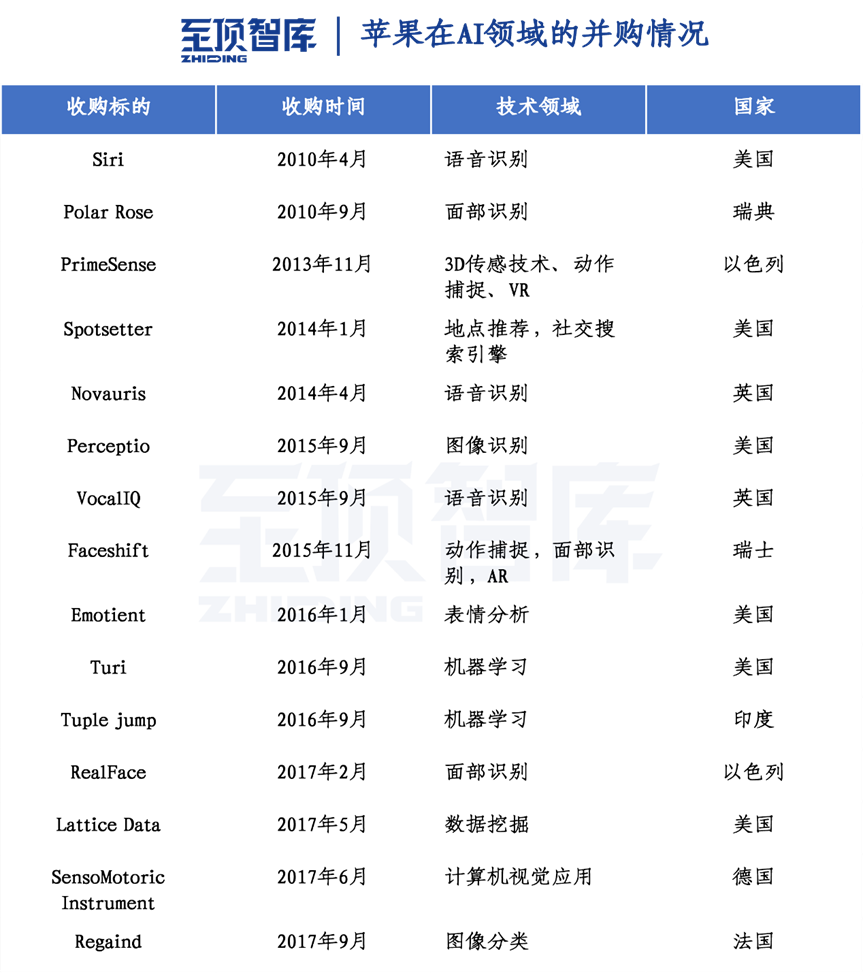

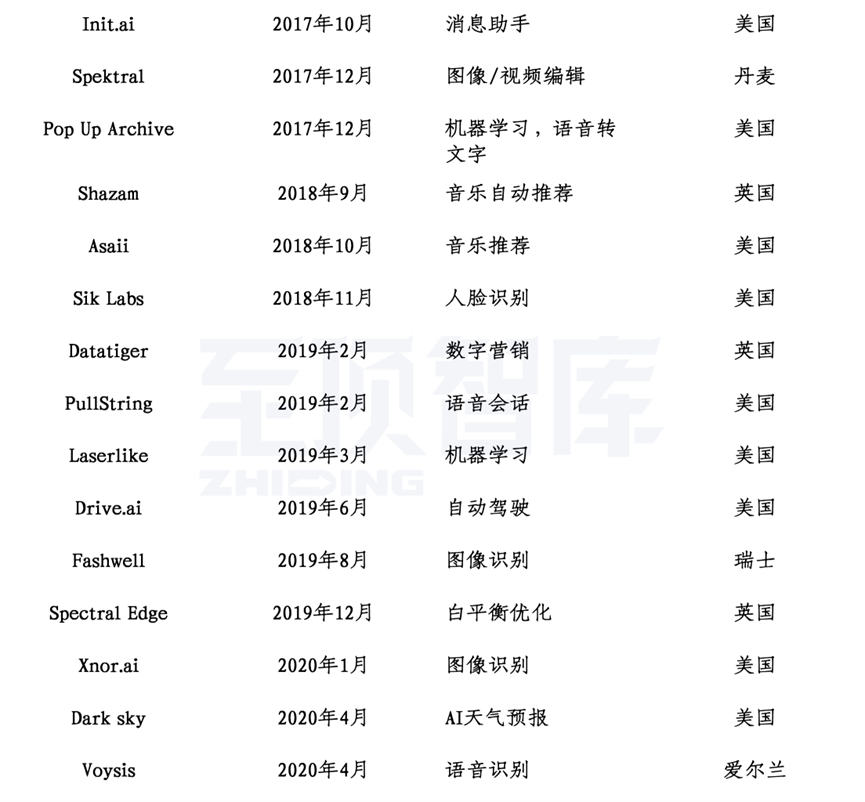

在人工智能领域,苹果以「并购+自研」的方式,一方面收购相关的AI初创公司,另一方面自研,完成AI硬件开发到软件应用的落地。2011年以来,苹果相继推出Siri智能语音助手,Face ID人脸识别系统,苹果AI芯片等产品。2024年作为苹果在人工智能发力的关键之年,AI手机、AI应用及AI大模型成为焦点。

至顶智库将从2024年苹果秋季发布会的重磅新品及AI技术出发,通过回顾苹果的AI发展史,讲述苹果在人工智能的发展之路。

2024苹果秋季发布会,iPhone 16系列AI手机发布

2024年9月10日凌晨1点(北京时间),苹果召开秋季新品发布会,至顶智库将重点介绍iPhone 16系列产品情况。

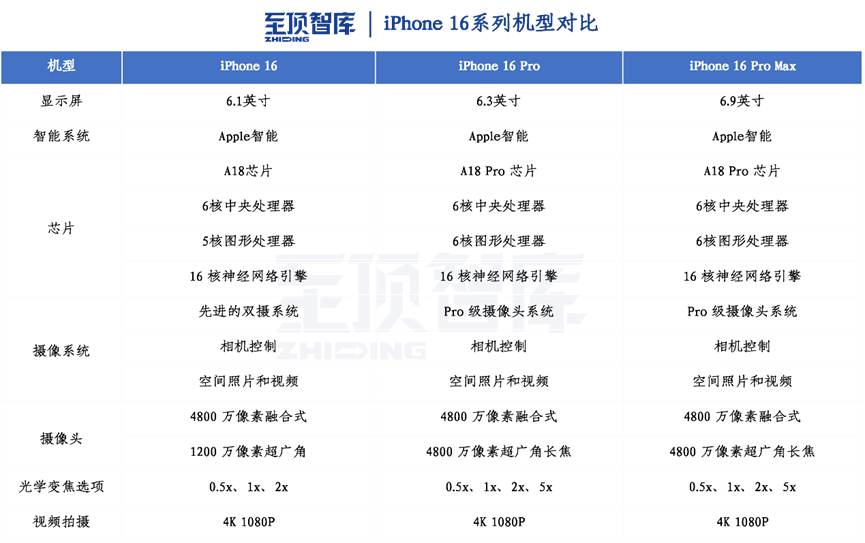

全新iPhone 16系列推出iPhone 16、iPhone 16 Plus、iPhone 16 Pro和iPhone 16 Pro Max四款机型,其中前两者将首发A18芯片;后两者将首发搭载A18 Pro芯片。

Pro版有两个尺寸可选,iPhone 16 Pro为6.3英寸,iPhone 16 Pro Max为6.9英寸。储存容量方面,iPhone 16 Pro 提供128GB、256GB、512GB、1TB,iPhone 16 Pro Max提供256GB、512GB、1TB。

外观设计

外观方面,iPhone 16 Pro采用5级钛金属设计,全新微喷砂工艺,带来更加细腻精致的外观。钛的强度重量比超过绝大多数金属,以此打造的各款Pro机型都坚固、轻盈;机身内部设计包括100%再生铝金属散热结构结合玻璃背板的一系列优化,散热能力进一步增强;借助全新显示屏技术,在有效像素区域走线来无失真传输显示数据。这种方式能将屏幕边框做得更窄。

iPhone 16提供5种配色,有两个尺寸可供选择,包括了6.1英寸的iPhone 16和 6.7英寸的iPhone 16 Plus,采用双摄像头垂直排列。储存容量可选128GB、256GB和512GB;首次支持MagSafe快速充电,通过30W充电器,充电功率可达25W,同时支持最高15W无线充电。标准版也配备去年Pro机型上首次亮相的Action按钮,取代静音开关,并且可自定义。用户可以将其设置为激活手电筒或语音备忘录录音,还可以触发快捷方式等功能。

Apple Intelligence

涵盖智能书写、智能绘图、智能总结、新版Siri等功能。Apple Intelligence功能,美国英语版会在下个月率先上线,而支持中文的智能应用2025年开始上线。

写作工具可以校对文本并重写不同版本,调整语气和措辞,轻点即可总结所选文本。可在任何地方写作使用,包括第三方应用程序。只需在Notes或电话应用程序中点击录制即可捕获录音和文稿。Apple Intelligence会生成文稿摘要,可以快速获得重要信息。邮件中的优先消息将时间敏感的消息提升到收件箱的顶部 - 例如今天有截止日期的邀请或今天下午航班的登机提醒。

智能总结功能可以对于电子邮件、信息通知等提供快速内容摘要,让用户高效获取各类信息。

Siri能够以独有的方式为个人提供帮助。例如,预订航班时需要护照号码,Siri可以帮忙找到所需信息,而不会侵犯个人隐私。更丰富的语言理解和增强的语音使与Siri交流更加自然。例如,如果说话磕磕巴巴,Siri仍然知道在说什么。不确定如何在iPhone上操作,例如调整肖像的背景虚化,凭借广泛产品知识,Siri可快速为提供分步说明。

A18 Pro芯片

A18 Pro芯片搭载于iPhone 16 Pro,该芯片同样采用了第二代3nm工艺,拥有16核神经引擎,每秒可以处理35万亿次运算,速度更快且能效更高,内存带宽提升了17%;A18 Pro的6核CPU,相比A17 Pro最高提速15%,耗电减少20%,缓存比A18更大。芯片内置新一代机器学习加速器,能帮助驱动Apple Intelligence,可直接通过编程控制来实现高能效、高吞吐率、低延迟的运算;A18 Pro全新6核GPU,优化了芯片图形性能,其GPU速度最高比A17 Pro快20%。

A18 Pro先进媒体处理功能,如全新显示引擎,能驱动ProMotion技术和全天候显示。A18 Pro支持更快的USB 3和ProRes视频拍摄,还有全新视频编码器、图像信号处理器。

A18芯片

全新A18芯片搭载于iPhone 16,采用第二代3nm工艺,CPU为6核心,包括2个性能核心和4个效率核心。A18 CPU比iPhone 15的A16仿生芯片CPU提速30%。A18芯片搭载了16核神经网络引擎,并针对大型生成模型进行优化,机器学习速度最高提升2倍,内存带宽增加17%。

照片和视频

拍摄方面,iPhone16系列在设备侧面新增了一个新的电容式“相机控制”按钮,滑动手指即可调整曝光、景深等相机功能,还能切换各个镜头或使用数码变焦取景构图。按一下启动相机 app,再按一下秒拍照片;在视频模式下,一按即可开拍视频;轻按一下可打开变焦等各种控制选项;轻按两下可切换选择其他相机设置。选好后滑动手指即可调整相应设置。

全新超广角摄像头带自动对焦,可拍摄清晰锐利的微距照片和视频。光圈和像素尺寸双双加大,进光量最高提升至2.6倍。iPhone 16摄像头采用新布局,能使用空间拍摄功能,拍摄3D照片和视频,并在Apple Vision Pro 上欣赏。

iPhone 16 Pro视频拍摄能力跃升,支持4K 120fps杜比视界格式,分辨率和帧率再创新高。全新4800万像素融合式摄像头搭载第二代四合一像素传感器,配合A18 Pro芯片,iPhone 16 Pro拍普通视频和慢动作视频,都能以4K 120fps杜比视界格式来录制。iPhone 16 Pro还搭载四个录音棚级麦克风,录制品质更高,让音频表现大幅提升。新的空间音频录制功能还可为视频带来更具沉浸感的音效。

苹果AI发展史

苹果大举收购30余家AI初创公司

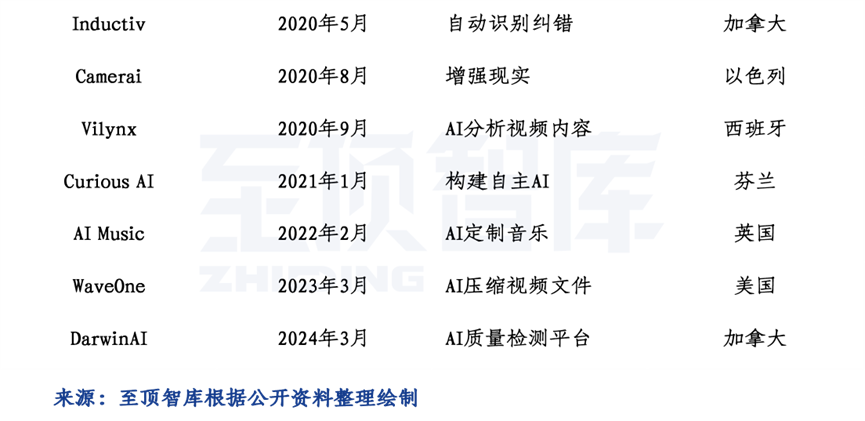

苹果在AI领域收购企业动作频频,将AI技术与产品不断融合。从2010年收购Siri开始,苹果在10年时间里收购多达30余家AI初创公司,2017年和2019年年均收购企业数量达到6家以上。2021年起,苹果收购AI公司的节奏有所放缓,但依旧拿下CuriousAI、AI Music、WaveOne、DarwinAI等初创公司,所收购的AI企业主要涉及语音识别、图像识别、机器学习、AI应用等多个细分领域。

智能语音助手Siri

Siri项目始于2003年斯坦福大学计算和自然语言中心研究项目,也是美国国防高级研究计划局(DARPA)资助的CALO项目分支,项目目标是创建虚拟语音助手;2007年引入外部资金成立Siri公司。2010年2月,Siri作为一款iPhone应用程序发布,同年4月苹果在乔布斯领导下收购Siri公司。2011年10月,Siri语音助手在iPhone 4S上正式推出,成为苹果自然语言处理和语音识别领域的里程碑。Siri作为一款语音助手,可以在各类苹果设备中使用,通过Siri查询天气、查询全球城市时间、设置闹钟、查询股票信息、寻找餐厅、地图和导航、阅读和回复消息、日程安排、搜索网页、语音拨号、播放音乐等。

2011年首次推出之后,Siri底层技术不断改进。2012年,苹果在第三代iPad上推出了Siri。2013年,Siri支持普通话、日语、俄语等语言。2014年,苹果推出“Hey Siri”,允许用户通过语音方式取代按钮方式激活Siri。2016年,苹果开放第三方API接入Siri,用户可通过第三方应用程序与Siri交互,执行发短信、预定旅行和付款等任务。2016年,用户可以在Mac电脑上与Siri交互。2018年,苹果发布HomePod智能音箱,融入Siri允许用户通过语音与虚拟助手交互。2020年,Siri允许用户将整句话翻译为不同语言,还与Apple Music等其他应用程序集成。2021年,Siri能更好理解方言和地区口音、方便视觉障碍人群使用,还被集成到智能家居生态系统中,可通过语音控制智能家居设备。

面部识别系统Face ID

Face ID是苹果推出的面部识别系统,于2017年9月首次搭载于iPhone X,可用于iPhone、iPad等设备解锁和支付。Face ID技术是基于PrimeSense公司之前在低成本红外深度感知方面的工作。2013年11月苹果收购PrimeSense,关键技术是通过视觉让设备获得对真实世界的三维感知能力。

Face ID是一种面部识别传感器,其由两个主要部分组成:1)垂直腔面发射激光点投影模块:该模块负责向用户的脸部投射超过30,000个红外光点。这些光点是通过激光发射器产生的,并且使用一种称为主动衍射光学元件(ADE)的技术来将激光束分割成30,000个光点。2)红外摄像头模块:该模块的功能是读取由激光投影模块投射出的红外光点形成的图案。通过分析这些光点的分布和形状,Face ID系统能够识别和验证用户的面部特征。Face ID通过投射大量红外光点到用户脸上,并用红外摄像头捕捉这些光点形成的图案,来实现面部识别的功能。

苹果AI系列芯片(A系列/M系列)

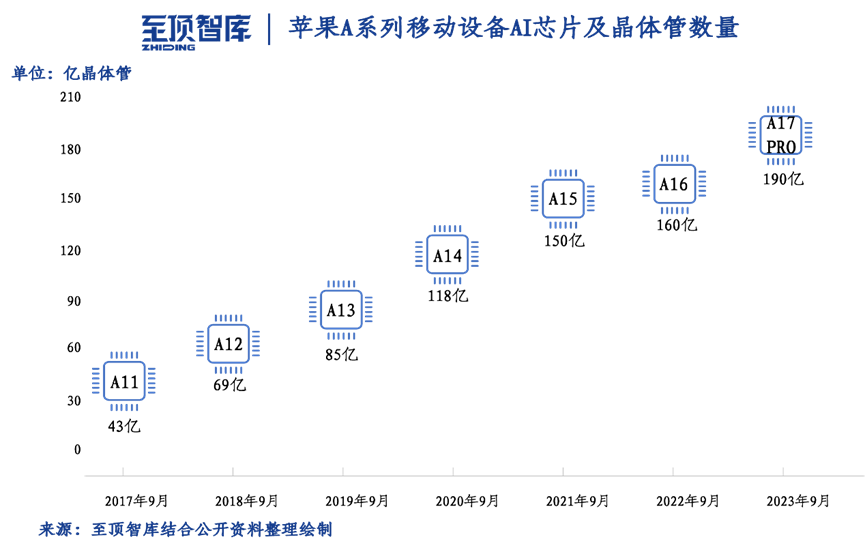

苹果发布的第一个包含神经网络引擎的芯片是Apple A11 Bionic,首次搭载于2017年发布的iPhone 8、8 plus和iPhone X。A11集成64位ARM架构的CPU、苹果自研三核GPU、NPU(神经网络引擎)等器件,从A11到A17,苹果每年9月定期进行一次更新,芯片晶体管数量显著提升。A11芯片搭载于iphone8和X系列,拥有43亿个晶体管,双核神经网络引擎每秒最高可进行6000亿次运算;A14芯片搭载于iphone12,共有118亿个晶体管,16核神经网络引擎每秒可进行11万亿次运算;A17 Pro芯片搭载于iPhone15 Pro系列,共有190亿个晶体管,16核神经网络引擎。

除苹果A系列芯片以外,M系列芯片均采用神经网络引擎。苹果M1芯片于2020年11月发布,搭载于Mac台式机、笔记本以及iPad Pro、iPad Air,拥有160亿个晶体管,16核神经网络引擎。M2芯片于2022年6月发布,拥有200亿个晶体管,Vision Pro也搭载了M2芯片。M3芯片发布于2023年10月,搭载250亿个晶体管,16核神经网络引擎。

Apple Intelligence

2024年6月WWDC大会,苹果推出Apple Intelligence,深度集成于iOS 18、iPadOS 18和macOS Sequoia中,带来文本和图像处理、Siri智能升级等重要更新。文本处理引入新工具Writing Tools,增强用户写作能力;图像处理涵盖Image Playground、照片和视频搜索回忆等功能,发布新版Siri,与OpenAI合作将ChatGPT智能应用植入苹果手机中。

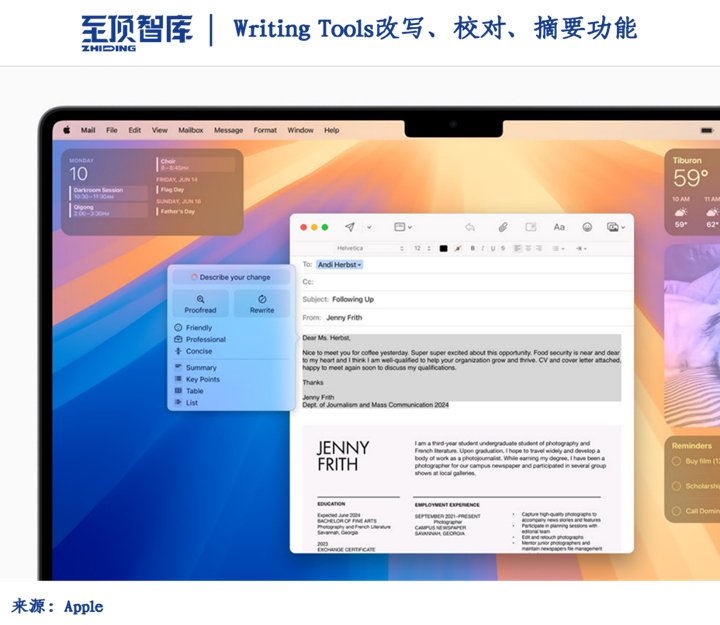

1)Writing Tools:让用户能在任何场景下对文本进行改写、校对和摘要,包括邮件、备忘录、Pages文稿和各类第三方app。改写工具可以让用户选择不同版本,根据用户和文稿诉求调整文风。Proofread 工具能为用户检查语法、措辞和语句结构,同时给出修改建议,以及对修改建议的说明,方便用户查看或快速采纳。Summarize 工具可在用户选中文本后,以易于理解的段落、要点罗列、表格或列表的形式对其进行归纳总结。

2)Image Playground:借助于Image Playground,用户可在数秒间创作出趣味图像,有动画、插画、手绘三种样式可以选择。Image Playground直接内置在信息等多款app中,也可单独进行安装和使用,适合试验不同创意和风格。所有图像均在设备端创建生成,不受图像数量限制。

在信息app中使用Image Playground,可让用户快速创作出趣味图像发送给朋友,甚至还会看到基于当前对话生成的个性化创意推荐;在备忘录app中,用户可通过Apple Pencil工具盘中新增的Image Wand工具调用Image Playground,为笔记添加更多视觉表达趣味性。手绘草图可以转化成精美图像,用户还可选中其中空白区域,利用基于周围元素生成的场景信息生成新图像。

3)新版Siri:在Apple Intelligence助力下,Siri与系统体验结合更加浑然一体。Siri语言理解能力提升,表现得更自然,更契合场景,更贴合用户个人需求,还能简化和加快日常任务流程。Siri能理解用户碎片化表述,还会为连续请求沿用语境场景。Siri可为用户提供设备支持,回答数千个有关如何使用iPhone、iPad和Mac的问题。

Siri具备屏幕感知能力,能够理解用户在更多app中的内容,并据其进行相应操作。例如,用户在信息app中收到朋友发来的新地址时,只需说一句“把这个地址加到他的联系人名片里”即可。

Siri能在各类Apple及第三方app中完成数百种新操作。例如,用户只需说出“从我的阅读列表里调出那篇关于蝉的文章”,或者“把周六那天的烧烤照片发给 Malia”,Siri便会执行。

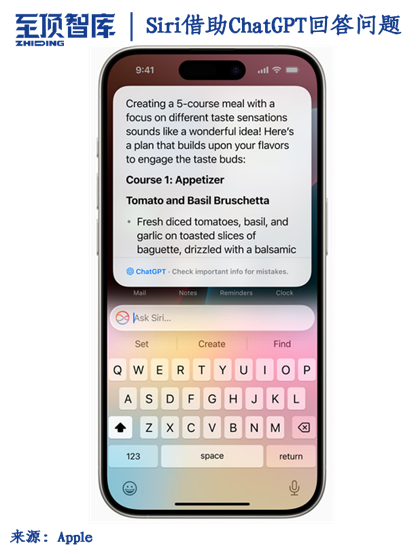

4)ChatGPT接入:Apple将ChatGPT整合至iOS 18、iPadOS 18和macOS Sequoia操作体验中,让用户能够直接使用ChatGPT的特殊功能,包括图像和文档理解能力,为用户省去切换工具时间。

Siri可根据需要直接调用ChatGPT特殊功能。征得用户同意后,才将问题发送至 ChatGPT,连同任何文档或照片,最后直接答复用户。

ChatGPT集成至Writing Tools工具内,协助用户根据当前主题生成内容。使用Compose功能时,用户可运用ChatGPT图像工具生成多种图像,做到图文并茂。

苹果自研AI大模型

2024年7月,苹果发表Apple Intelligence Foundation Language Models论文,首次披露苹果自研大模型的细节信息。

Apple Intelligence由多个高性能的生成式模型组成,可实现写作和优化文字、对通知排序和总结、创作图片、简化跨程序交互。论文着重介绍了两个模型的构建过程:AFM-on-device和AFM-server(AFM代表苹果基础模型Apple Foundation Model)。

AFM-on-device是30亿参数的模型,可在端侧高效运行。AFM-on-device在2048块TPUv5p芯片上训练,从更大模型蒸馏和剪枝而来。

AFM-server是一个基于服务器的大语言模型,用于私有云计算。AFM-server在8192块TPUv4芯片上从头开始训练,训练数据集共6.3T token。

AFM 分为三个阶段:1)核心阶段:AFM-server从头开始,AFM-on-device从更大模型蒸馏和剪枝;2)继续阶段:减少低质量网页爬取数据权重,增加代码和数学数据权重;3)上下文扩展阶段:使用更长的序列长度和合成长文本数据,以提高模型对长文本的处理能力。后训练过程包含两个阶段:监督微调(SFT)和人类反馈强化学习(RLHF)。Apple提出两种新的训练后算法:(1)迭代教学委员会(iTeC):使用多种偏好优化算法,包括拒绝采样、直接偏好优化和在线强化学习,迭代模型。(2)在线RLHF算法:使用 Mirror Descent策略优化和 Leave-One-Out优势估计器(MDLOO)来最大化奖励,提高模型质量。

适配器架构 :苹果使用LoRA适配器来针对特定任务进行模型微调。对于每项任务,研究者会调整 AFM 自注意力层中的所有线性投影矩阵以及逐点前馈网络中的全连接层。仅通过微调适配器,基础预训练模型的原始参数保持不变,可以保留模型的一般知识,同时定制适配器以支持特定任务。

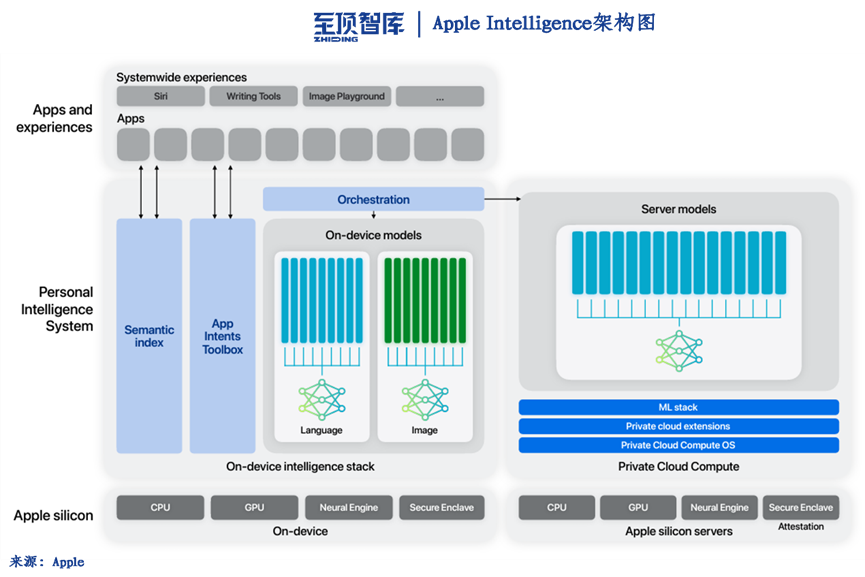

Apple Intelligence整体架构分为底层硬件设施、中间层个人智能系统和顶层应用。端侧模型是由端侧本身硬件提供支撑,包括CPU、GPU、神经网络引擎和安全系统。服务器模型则是由服务器硬件支持。个人智能系统包括语义索引、程序意图工具箱、端侧语言模型、端侧图像模型、服务器模型及相关系统等。支持的应用包括Siri、写作工具、图像生成等。

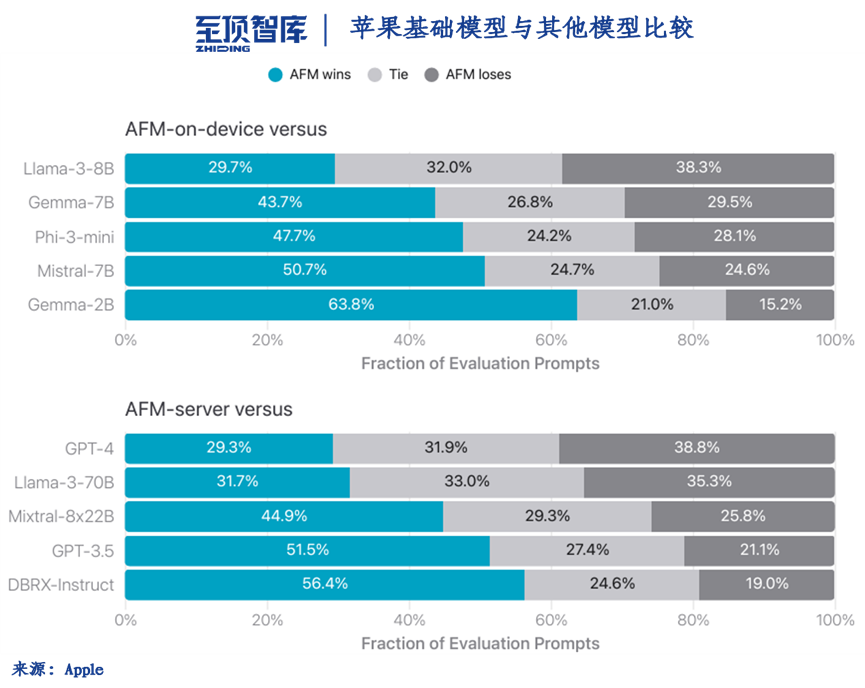

Apple将AFM与开源模型(Phi-3、Gemma-1.1、Llama-3、Mistral、DBRX-Instruct)和商业模型(GPT-3.5和GPT-4)进行比较。AFM-on-device与Phi-3-mini相比,模型尺寸小25%,仍获得47.7%胜率。

苹果AI大模型核心技术团队

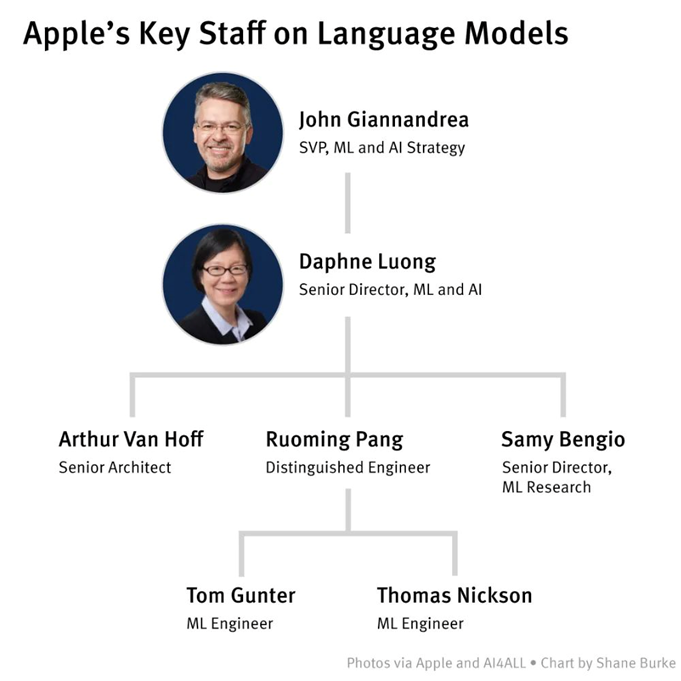

Van Hoff、Giannandrea、Pang三位技术大佬在不同程度上对苹果的AI大模型发展起到重要推动作用。

Arthur Van Hoff:作为苹果大语言模型带头人,曾开发新版Siri。Van Hoff是Sun Microsystems团队的早期成员,该团队在20世纪90年代创造Java,后来Van Hoff成为知名企业家。2019年,Van Hoff加入苹果,一开始负责开发内部代号为Blackbird的新版Siri,但苹果最终放弃该项目。随后,Van Hoff的团队开始专注于大语言模型,最初的目标是开发出用于Blackbird的模型基础版本。Van Hoff团队最初只有几名成员,其中最著名的是两名专门从事自然语言处理的英国研究人员Tom Gunter和Thomas Nickson。这两名研究人员都曾在牛津大学获得高级学位,并于2016年加入苹果公司从事Siri的研发工作。

John Giannandrea:苹果大语言模型主推人。Giannandrea是前谷歌AI部门主管,在2018年加入苹果。一开始加入苹果公司是为了改进Siri,并将更多的机器学习技术融入苹果的软件中。加入苹果后,Giannandrea帮苹果公司招募到来自谷歌的关键工程师和研究人员。四年前,Giannandrea组建一个名为Foundational Models的团队来开发大语言模型,这个团队规模不大,大概有16个人。

Ruoming Pang:苹果大语言模型的训练者。2021年,在谷歌工作15年的Pang加入苹果,帮助苹果训练最先进的大语言模型。Pang在神经网络方面的研究工作有很高的声誉。神经网络是机器学习的一个分支领域,涉及到训练软件以识别数据中的模式和关系,类似于人脑的工作原理。他有一些比较著名的研究,如涉及神经网络如何与手机处理器配合工作,以及如何使用并行计算来训练神经网络。其中,并行计算是将较大的问题分解为较小的任务,以方便多个处理器能够同时进行计算的过程。

来源:至顶网至顶智库频道

好文章,需要你的鼓励